Package java.util.concurrent Description

Utility classes commonly useful in concurrent programming. This package includes a few small standardized extensible frameworks, as well as some classes that provide useful functionality and are otherwise tedious or difficult to implement. Here are brief descriptions of the main components. See also the java.util.concurrent.locks and java.util.concurrent.atomic packages.

Executors

Interfaces.

Executoris a simple standardized interface for defining custom thread-like subsystems, including thread pools, asynchronous I/O, and lightweight task frameworks. Depending on which concrete Executor class is being used, tasks may execute in a newly created thread, an existing task-execution thread, or the thread calling execute, and may execute sequentially or concurrently.

ExecutorService provides a more complete asynchronous task execution framework. An ExecutorService manages queuing and scheduling of tasks, and allows controlled shutdown.

The ScheduledExecutorService subinterface and associated interfaces add support for delayed and periodic task execution. ExecutorServices provide methods arranging asynchronous execution of any function expressed as Callable, the result-bearing analog of Runnable.

A Future returns the results of a function, allows determination of whether execution has completed, and provides a means to cancel execution.

A RunnableFuture is a Future that possesses a run method that upon execution, sets its results.

Implementations.

Classes ThreadPoolExecutorand ScheduledThreadPoolExecutorprovide tunable, flexible thread pools.

The Executors class provides factory methods for the most common kinds and configurations of Executors, as well as a few utility methods for using them. Other utilities based on Executors include the concrete class FutureTask providing a common extensible implementation of Futures, andExecutorCompletionService, that assists in coordinating the processing of groups of asynchronous tasks.

Class ForkJoinPool provides an Executor primarily designed for processing instances of ForkJoinTask and its subclasses. These classes employ a work-stealing scheduler that attains high throughput for tasks conforming to restrictions that often hold in computation-intensive parallel processing.

Queues

The ConcurrentLinkedQueue class supplies an efficient scalable thread-safe non-blocking FIFO queue. The ConcurrentLinkedDeque class is similar, but additionally supports the Deque interface.

Five implementations in java.util.concurrent support the extended BlockingQueue interface, that defines blocking versions of put and take:LinkedBlockingQueue, ArrayBlockingQueue, SynchronousQueue, PriorityBlockingQueue, and DelayQueue. The different classes cover the most common usage contexts for producer-consumer, messaging, parallel tasking, and related concurrent designs.

Extended interface TransferQueue, and implementation LinkedTransferQueueintroduce a synchronous transfer method (along with related features) in which a producer may optionally block awaiting its consumer.

The BlockingDeque interface extends BlockingQueue to support both FIFO and LIFO (stack-based) operations. Class LinkedBlockingDeque provides an implementation.

Timing

The TimeUnit class provides multiple granularities (including nanoseconds) for specifying and controlling time-out based operations. Most classes in the package contain operations based on time-outs in addition to indefinite waits. In all cases that time-outs are used, the time-out specifies the minimum time that the method should wait before indicating that it timed-out. Implementations make a “best effort” to detect time-outs as soon as possible after they occur. However, an indefinite amount of time may elapse between a time-out being detected and a thread actually executing again after that time-out. All methods that accept timeout parameters treat values less than or equal to zero to mean not to wait at all. To wait “forever”, you can use a value of Long.MAX_VALUE.

Synchronizers

Five classes aid common special-purpose synchronization idioms.

Semaphore is a classic concurrency tool.CountDownLatch is a very simple yet very common utility for blocking until a given number of signals, events, or conditions hold.- A

CyclicBarrier is a resettable multiway synchronization point useful in some styles of parallel programming.

- A

Phaser provides a more flexible form of barrier that may be used to control phased computation among multiple threads.

- An

Exchanger allows two threads to exchange objects at a rendezvous point, and is useful in several pipeline designs.

Concurrent Collections

Besides Queues, this package supplies Collection implementations designed for use in multithreaded contexts: ConcurrentHashMap,ConcurrentSkipListMap, ConcurrentSkipListSet, CopyOnWriteArrayList and CopyOnWriteArraySet. When many threads are expected to access a given collection, a ConcurrentHashMap is normally preferable to a synchronized HashMap, and a ConcurrentSkipListMap is normally preferable to a synchronized TreeMap. A CopyOnWriteArrayList is preferable to a synchronized ArrayList when the expected number of reads and traversals greatly outnumber the number of updates to a list.

The “Concurrent” prefix used with some classes in this package is a shorthand indicating several differences from similar “synchronized” classes. For example java.util.Hashtable and Collections.synchronizedMap(new HashMap()) are synchronized. But ConcurrentHashMapis “concurrent”. A concurrent collection is thread-safe, but not governed by a single exclusion lock. In the particular case of ConcurrentHashMap, it safely permits any number of concurrent reads as well as a tunable number of concurrent writes. “Synchronized” classes can be useful when you need to prevent all access to a collection via a single lock, at the expense of poorer scalability. In other cases in which multiple threads are expected to access a common collection, “concurrent” versions are normally preferable. And unsynchronized collections are preferable when either collections are unshared, or are accessible only when holding other locks.

Most concurrent Collection implementations (including most Queues) also differ from the usual java.util conventions in that their Iterators and Spliterators provide weakly consistent rather than fast-fail traversal:

- they may proceed concurrently with other operations

- they will never throw

ConcurrentModificationException

- they are guaranteed to traverse elements as they existed upon construction exactly once, and may (but are not guaranteed to) reflect any modifications subsequent to construction.

Memory Consistency Properties

Chapter 17 of the Java Language Specification defines the happens-before relation on memory operations such as reads and writes of shared variables. The results of a write by one thread are guaranteed to be visible to a read by another thread only if the write operation happens-before the read operation. The synchronized and volatile constructs, as well as the Thread.start() and Thread.join() methods, can form happens-before relationships. In particular:

- Each action in a thread happens-before every action in that thread that comes later in the program’s order.

- An unlock (

synchronized block or method exit) of a monitor happens-before every subsequent lock (synchronized block or method entry) of that same monitor. And because the happens-before relation is transitive, all actions of a thread prior to unlocking happen-before all actions subsequent to any thread locking that monitor.

- A write to a

volatile field happens-before every subsequent read of that same field. Writes and reads of volatile fields have similar memory consistency effects as entering and exiting monitors, but do not entail mutual exclusion locking.

- A call to

start on a thread happens-before any action in the started thread.

- All actions in a thread happen-before any other thread successfully returns from a

join on that thread.

The methods of all classes in java.util.concurrent and its subpackages extend these guarantees to higher-level synchronization. In particular:

-

Actions in a thread prior to placing an object into any concurrent collection happen-before actions subsequent to the access or removal of that element from the collection in another thread.

-

Actions in a thread prior to the submission of a Runnable to an Executor happen-before its execution begins. Similarly for Callables submitted to an ExecutorService.

-

Actions taken by the asynchronous computation represented by a Future happen-before actions subsequent to the retrieval of the result via Future.get() in another thread.

-

Actions prior to “releasing” synchronizer methods such as Lock.unlock, Semaphore.release, and CountDownLatch.countDown happen-before actions subsequent to a successful “acquiring” method such as Lock.lock, Semaphore.acquire, Condition.await, and CountDownLatch.awaiton the same synchronizer object in another thread.

-

For each pair of threads that successfully exchange objects via an Exchanger, actions prior to the exchange() in each thread happen-before those subsequent to the corresponding exchange() in another thread.

-

Actions prior to calling CyclicBarrier.await and Phaser.awaitAdvance (as well as its variants) happen-before actions performed by the barrier action, and actions performed by the barrier action happen-before actions subsequent to a successful return from the corresponding await in other threads.

-

Since:

1.5

Unsafe

JDK的rt.jar包中的Unsafe类提供了硬件级别的原子性操作,Unsafe类中的方法都是native方法,它们使用JNI的方式访问本地C++实现库。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

public class TestUnsafe {

static final Unsafe unsafe = Unsafe.getUnsafe();

static final long stateOffset;

private volatile long state = 0;

static {

try {

stateOffset = unsafe.objectFieldOffset(TestUnsafe.class.getDeclaredField("state"));

} catch (Exception e) {

System.out.println(e.getLocalizedMessage());

throw new Error(e);

}

}

public static void main(String[] args) {

TestUnsafe test = new TestUnsafe();

boolean success = unsafe.compareAndSwapInt(test, stateOffset, 0, 1);

System.out.println(success);

}

}

|

Exception in thread “main” java.lang.ExceptionInInitializerError

Caused by: java.lang.SecurityException: Unsafe

at sun.misc.Unsafe.getUnsafe(Unsafe.java:90)

at chapter01.TestUnsafe.(TestUnsafe.java:6)

Unsafe源码:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

private static final Unsafe theUnsafe = new Unsafe();

@CallerSensitive

public static Unsafe getUnsafe() {

Class<?> caller = Reflection.getCallerClass();

if (!VM.isSystemDomainLoader(caller.getClassLoader()))

throw new SecurityException("Unsafe");

return theUnsafe;

}

/**

* Returns true if the given class loader is in the system domain

* in which all permissions are granted.

*/

public static boolean isSystemDomainLoader(ClassLoader loader) {

return loader == null;

}

|

上述代码判断是不是Bootstrap类加载器加载的localClass,在这里是看是不是Bootstrap加载器加载了TestUnSafe.class。很明显由于TestUnSafe.class是使用AppClassLoader加载的,所以这里直接抛出了异常。

Unsafe类是rt.jar包提供的,rt.jar包里面的类是使用Bootstrap类加载器加载的,而我们的启动main函数所在的类是使用AppClassLoader加载的,所以在main函数里面加载Unsafe类时,根据委托机制,会委托给Bootstrap去加载Unsafe类。

如果没有这个限制,那么应用程序就可以随意使用Unsafe做事情了,而Unsafe类可以直接操作内存,这是不安全的,所以JDK开发组特意做了这个限制,不让开发人员在正规渠道使用Unsafe类,而是在rt.jar包里面的核心类中使用Unsafe功能。

解决方法:使用万能的反射来获取Unsafe实例方法。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

|

public class TestUnsafe {

static final Unsafe unsafe;

static final long stateOffset;

private volatile long state = 0;

static {

try {

//使用反射获取Unsafe的成员变量theUnsafe

Field field = Unsafe.class.getDeclaredField("theUnsafe");

field.setAccessible(true);

unsafe = (Unsafe) field.get(null);

stateOffset = unsafe.objectFieldOffset(TestUnsafe.class.getDeclaredField("state"));

} catch (Exception e) {

System.out.println(e.getLocalizedMessage());

throw new Error(e);

}

}

public static void main(String[] args) {

TestUnsafe test = new TestUnsafe();

boolean success = unsafe.compareAndSwapInt(test, stateOffset, 0, 1);

System.out.println(success);

}

}

|

true

线程池

- 工作者线程:工作者线程主体就是一个循环,循环从队列中接受任务并执行

- 任务队列:任务队列保存待执行的任务

interface Executor

Executor表示最简单的执行服务,其定义为:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

public interface Executor {

/**

* Executes the given command at some time in the future. The command

* may execute in a new thread, in a pooled thread, or in the calling

* thread, at the discretion of the {@code Executor} implementation.

*

* @param command the runnable task

* @throws RejectedExecutionException if this task cannot be

* accepted for execution

* @throws NullPointerException if command is null

*/

void execute(Runnable command);

}

|

void execute(Runnable command);可以执行一个Runnable,没有返回结果。

接口没有限定任务如何执行,可能是创建一个新线程,可能是在调用者线程中执行,也可能是复用线程池中的某个线程。

Executor:

An object that executes submitted Runnable tasks. This interface provides a way of decoupling task submission from the mechanics of how each task will be run, including details of thread use, scheduling, etc.

新线程:

An Executor is normally used instead of explicitly creating threads. For example, rather than invoking new Thread(new(RunnableTask())).start() for each of a set of tasks, you might use:

1

2

3

4

|

Executor executor = anExecutor;

executor.execute(new RunnableTask1());

executor.execute(new RunnableTask2());

...

|

调用者线程:

However, the Executor interface does not strictly require that execution be asynchronous. In the simplest case, an executor can run the submitted task immediately in the caller's thread:

1

2

3

4

5

|

class DirectExecutor implements Executor {

public void execute(Runnable r) {

r.run();

}

}

|

线程池:

More typically, tasks are executed in some thread other than the caller’s thread. The executor below spawns a new thread for each task.

1

2

3

4

5

|

class ThreadPerTaskExecutor implements Executor {

public void execute(Runnable r) {

new Thread(r).start();

}

}

|

Many Executor implementations impose some sort of limitation on how and when tasks are scheduled. The executor below serializes the submission of tasks to a second executor, illustrating a composite executor.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

|

class SerialExecutor implements Executor {

final Queue<Runnable> tasks = new ArrayDeque<Runnable>();

final Executor executor;

Runnable active;

SerialExecutor(Executor executor) {

this.executor = executor;

}

public synchronized void execute(final Runnable r) {

tasks.offer(new Runnable() {

public void run() {

try {

r.run();

} finally {

scheduleNext();

}

}

});

if (active == null) {

scheduleNext();

}

}

protected synchronized void scheduleNext() {

if ((active = tasks.poll()) != null) {

executor.execute(active);

}

}

}

|

The Executor implementations provided in this package implement ExecutorService, which is a more extensive interface.

1

|

public interface ExecutorService extends Executor

|

The ThreadPoolExecutor class provides an extensible thread pool implementation.

The Executors class provides convenient factory methods for these Executors.

Memory consistency effects: Actions in a thread prior to submitting a Runnable object to an Executor happen-before its execution begins, perhaps in another thread.

interface ExecutorService extends Executor

ExecutorService扩展了Executor,定义了更多服务,基本方法有:

1

2

3

4

5

6

|

public interface ExecutorService extends Executor {

<T> Future<T> submit(Callable<T> task);

<T> Future<T> submit(Runnable task, T result);

Future<?> submit(Runnable task);

...

}

|

这三个submit都表示提交一个任务,返回值类型都是Future。

返回后,只是表示任务已提交,不代表已执行。

通过Future可以查询异步任务的状态、获取最终结果、取消任务等。

<T> Future<T> submit(Callable<T> task);

Submits a value-returning task for execution and returns a Future representing the pending results of the task. The Future’s get method will return the task’s result upon successful completion.

对于Callable,任务最终有个返回值

If you would like to immediately block waiting for a task, you can use constructions of the form result = exec.submit(aCallable).get();

Note: The Executorsclass includes a set of methods that can convert some other common closure-like objects, for example, PrivilegedActionto Callable form so they can be submitted.

<T> Future<T> submit(Runnable task, T result);

Submits a Runnable task for execution and returns a Future representing that task. The Future’s get method will return the given result upon successful completion.

提交Runnable的方法可以同时提供一个结果,在异步任务结束时返回

Future<?> submit(Runnable task);

Submits a Runnable task for execution and returns a Future representing that task. The Future’s get method will return null upon successful completion.

异步任务的最终返回值为null

关闭线程池

- shutdown:将线程池的状态设置成

SHUTDOWN状态,然后中断所有没有正在执行任务的线程。

- shutdownNow:首先将线程池的状态设置成

STOP,然后尝试停止所有的正在执行或暂停任务的线程,并返回等待执行任务的列表。

它们的原理是遍历线程池中的工作线程,然后逐个调用线程的interrupt方法来中断线程,所以无法响应中断的任务可能永远无法终止。

void shutdown();注释:

Initiates an orderly shutdown in which previously submitted tasks are executed, but no new tasks will be accepted. Invocation has no additional effect if already shut down.

This method does not wait for previously submitted tasks to complete execution. Use awaitTermination to do that.

List<Runnable> shutdownNow();注释:

Attempts to stop all actively executing tasks, halts the processing of waiting tasks, and returns a list of the tasks that were awaiting execution.

This method does not wait for actively executing tasks to terminate. Use awaitTerminationto do that.

There are no guarantees beyond best-effort attempts to stop processing actively executing tasks. For example, typical implementations will cancel via Thread.interrupt(), so any task that fails to respond to interrupts may never terminate.

Returns:

list of tasks that never commenced execution

shutdown和shutdownNow不会阻塞等待,它们返回后不代表所有任务都已结束,不过isShutdown方法会返回true。

调用者可以通过awaitTermination等待所有任务结束,它可以限定等待的时间,如果超时前所有任务都结束了,即isTerminated方法返回true,则返回true,否则返回false。

ExecutorService有两组批量提交任务的方法:invokeAll和invokeAny,它们都有两个版本,其中一个限定等待时间。

invokeAll等待所有任务完成,返回的Future列表中,每个Future的isDone方法都返回true,不过isDone为true不代表任务就执行成功了,可能是被取消了。invokeAll可以指定等待时间,如果超时后有的任务没完成,就会被取消。

而对于invokeAny,只要有一个任务在限时内成功返回了,它就会返回该任务的结果,其他任务会被取消;如果没有任务能在限时内成功返回,抛出TimeoutException;如果限时内所有任务都结束了,但都发生了异常,抛出ExecutionException。

abstract class AbstractExecutorService implements ExecutorService

class ThreadPoolExecutor extends AbstractExecutorService

JUC中线程池的实现类是ThreadPoolExecutor,它继承自AbstractExecutorService,实现了ExecutorService。

Creates a new ThreadPoolExecutor with the given initial parameters and default thread factory and rejected execution handler. It may be more convenient to use one of the Executors factory methods instead of this general purpose constructor.

1

2

3

4

5

6

7

8

|

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue) {

this(corePoolSize, maximumPoolSize, keepAliveTime, unit, workQueue,

Executors.defaultThreadFactory(), defaultHandler);

}

|

Creates a new ThreadPoolExecutor with the given initial parameters and default rejected execution handler.

1

2

3

4

5

6

7

8

9

|

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue,

ThreadFactory threadFactory) {

this(corePoolSize, maximumPoolSize, keepAliveTime, unit, workQueue,

threadFactory, defaultHandler);

}

|

Creates a new ThreadPoolExecutor with the given initial parameters and default thread factory.

1

2

3

4

5

6

7

8

9

|

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue,

RejectedExecutionHandler handler) {

this(corePoolSize, maximumPoolSize, keepAliveTime, unit, workQueue,

Executors.defaultThreadFactory(), handler);

}

|

Creates a new ThreadPoolExecutor with the given initial parameters.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

|

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue<Runnable> workQueue,

ThreadFactory threadFactory,

RejectedExecutionHandler handler) {

if (corePoolSize < 0 ||

maximumPoolSize <= 0 ||

maximumPoolSize < corePoolSize ||

keepAliveTime < 0)

throw new IllegalArgumentException();

if (workQueue == null || threadFactory == null || handler == null)

throw new NullPointerException();

this.acc = System.getSecurityManager() == null ?

null :

AccessController.getContext();

this.corePoolSize = corePoolSize;

this.maximumPoolSize = maximumPoolSize;

this.workQueue = workQueue;

this.keepAliveTime = unit.toNanos(keepAliveTime);

this.threadFactory = threadFactory;

this.handler = handler;

}

|

corePoolSize - the number of threads to keep in the pool, even if they are idle, unless allowCoreThreadTimeOut is set

corePoolSize(线程池的基本大小):当提交一个任务到线程池时,线程池会创建一个线程来执行任务,即使其他空闲的基本线程能够执行新任务也会创建线程,等到需要执行的任务数大于线程池基本大小时就不再创建。如果调用了线程池的prestartAllCoreThreads()方法,线程池会提前创建并启动所有基本线程。

maximumPoolSize - the maximum number of threads to allow in the pool

maximumPoolSize(线程池最大数量):线程池允许创建的最大线程数。如果队列满了,并且已创建的线程数小于最大线程数,则线程池会再创建新的线程执行任务。值得注意的是,如果使用了无界的任务队列这个参数就没什么效果。

keepAliveTime - when the number of threads is greater than the core, this is the maximum time that excess idle threads will wait for new tasks before terminating.

unit - the time unit for the keepAliveTime argument

workQueue - the queue to use for holding tasks before they are executed. This queue will hold only the Runnable tasks submitted by the execute method.

-

ArrayBlockingQueue:基于数组结构的有界阻塞队列,此队列按FIFO(先进先出)原则对元素进行排序。

-

LinkedBlockingQueue:基于链表结构的阻塞队列,此队列按FIFO排序元素,吞吐量通常要高于ArrayBlockingQueue。

静态工厂方法Executors.newFixedThreadPool()使用了这个队列。

-

SynchronousQueue:一个不存储元素的阻塞队列。每个插入操作必须等到另一个线程调用移除操作,否则插入操作一直处于阻塞状态,吞吐量通常要高于Linked-BlockingQueue。

静态工厂方法Executors.newCachedThreadPool()使用了这个队列。

-

PriorityBlockingQueue:一个具有优先级的无限阻塞队列。

threadFactory - the factory to use when the executor creates a new thread

handler - the handler to use when execution is blocked because the thread bounds and queue capacities are reached

ThreadPoolExecutor执行execute方法分下面4种情况。

1)如果当前运行的线程少于corePoolSize,则创建新线程来执行任务(注意,执行这一步骤需要获取全局锁)。

2)如果运行的线程等于或多于corePoolSize,则将任务加入BlockingQueue。

3)如果无法将任务加入BlockingQueue(队列已满),则创建新的线程来处理任务(注意,执行这一步骤需要获取全局锁)。

4)如果创建新线程将使当前运行的线程超出maximumPoolSize,任务将被拒绝,并调用RejectedExecutionHandler.rejectedExecution()方法。

RejectedExecutionHandler.rejectedExecution

任务拒绝策略

1

2

3

4

5

|

/**

* The default rejected execution handler

*/

private static final RejectedExecutionHandler defaultHandler =

new AbortPolicy();

|

默认情况下,提交任务的方法(如execute/submit/invokeAll等)会抛出异常,类型为RejectedExecutionException。

不过,拒绝策略是可以自定义的,ThreadPoolExecutor实现了4种处理方式。

1)ThreadPoolExecutor.AbortPolicy:这就是默认的方式,抛出异常。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

/**

* A handler for rejected tasks that throws a

* {@code RejectedExecutionException}.

*/

public static class AbortPolicy implements RejectedExecutionHandler {

/**

* Creates an {@code AbortPolicy}.

*/

public AbortPolicy() { }

/**

* Always throws RejectedExecutionException.

*

* @param r the runnable task requested to be executed

* @param e the executor attempting to execute this task

* @throws RejectedExecutionException always

*/

public void rejectedExecution(Runnable r, ThreadPoolExecutor e) {

throw new RejectedExecutionException("Task " + r.toString() +

" rejected from " +

e.toString());

}

}

|

2)ThreadPoolExecutor.DiscardPolicy:静默处理,忽略新任务,不抛出异常,也不执行。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

/**

* A handler for rejected tasks that silently discards the

* rejected task.

*/

public static class DiscardPolicy implements RejectedExecutionHandler {

/**

* Creates a {@code DiscardPolicy}.

*/

public DiscardPolicy() { }

/**

* Does nothing, which has the effect of discarding task r.

*

* @param r the runnable task requested to be executed

* @param e the executor attempting to execute this task

*/

public void rejectedExecution(Runnable r, ThreadPoolExecutor e) {

}

}

|

3)ThreadPoolExecutor.DiscardOldestPolicy:将等待时间最长的任务扔掉,然后自己排队。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

/**

* A handler for rejected tasks that discards the oldest unhandled

* request and then retries {@code execute}, unless the executor

* is shut down, in which case the task is discarded.

*/

public static class DiscardOldestPolicy implements RejectedExecutionHandler {

/**

* Creates a {@code DiscardOldestPolicy} for the given executor.

*/

public DiscardOldestPolicy() { }

/**

* Obtains and ignores the next task that the executor

* would otherwise execute, if one is immediately available,

* and then retries execution of task r, unless the executor

* is shut down, in which case task r is instead discarded.

*

* @param r the runnable task requested to be executed

* @param e the executor attempting to execute this task

*/

public void rejectedExecution(Runnable r, ThreadPoolExecutor e) {

if (!e.isShutdown()) {

e.getQueue().poll();

e.execute(r);

}

}

}

|

4)ThreadPoolExecutor.CallerRunsPolicy:在任务提交者线程中执行任务,而不是交给线程池中的线程执行。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

/**

* A handler for rejected tasks that runs the rejected task

* directly in the calling thread of the {@code execute} method,

* unless the executor has been shut down, in which case the task

* is discarded.

*/

public static class CallerRunsPolicy implements RejectedExecutionHandler {

/**

* Creates a {@code CallerRunsPolicy}.

*/

public CallerRunsPolicy() { }

/**

* Executes task r in the caller's thread, unless the executor

* has been shut down, in which case the task is discarded.

*

* @param r the runnable task requested to be executed

* @param e the executor attempting to execute this task

*/

public void rejectedExecution(Runnable r, ThreadPoolExecutor e) {

if (!e.isShutdown()) {

r.run();

}

}

}

|

它们都是ThreadPoolExecutor的public静态内部类,都实现了RejectedExecutionHandler接口。

拒绝策略只有在队列有界,且maximumPoolSize有限的情况下才会触发。

如果

- 队列无界:服务不了的任务总是会排队,请求处理队列可能会消耗非常大的内存,甚至引发内存不够的异常。

- 队列有界但maximumPoolSize无限:可能会创建过多的线程,占满CPU和内存,使得任何任务都难以完成。

所以,在任务量非常大的场景中,让拒绝策略有机会执行是保证系统稳定运行很重要的方面。

核心线程

线程个数小于等于corePoolSize时,我们称这些线程为核心线程,默认情况下。

class Executors 工厂类

ThreadPoolExecutor通常使用工厂类Executors来创建。Executors可以创建3种类型的ThreadPoolExecutor:FixedThreadPool、SingleThreadExecutor和CachedThreadPool。

类Executors提供了一些静态工厂方法,可以方便地创建一些预配置的线程池:

1

2

3

4

5

|

public static ExecutorService newFixedThreadPool(int nThreads) {

return new ThreadPoolExecutor(nThreads, nThreads,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>());

}

|

Creates a thread pool that reuses a fixed number of threads operating off a shared unbounded queue. At any point, at most nThreads threads will be active processing tasks. If additional tasks are submitted when all threads are active, they will wait in the queue until a thread is available. If any thread terminates due to a failure during execution prior to shutdown, a new one will take its place if needed to execute subsequent tasks. The threads in the pool will exist until it is explicitly shutdown.

使用固定数目的n个线程,使用无界队列LinkedBlockingQueue,线程创建后不会超时终止。和newSingleThreadExecutor一样,由于是无界队列,如果排队任务过多,可能会消耗过多的内存。

FixedThreadPool适用于为了满足资源管理的需求,而需要限制当前线程数量的应用场景,它适用于负载比较重的服务器。

1

2

3

4

5

6

|

public static ExecutorService newSingleThreadExecutor() {

return new FinalizableDelegatedExecutorService

(new ThreadPoolExecutor(1, 1,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>()));

}

|

Creates an Executor that uses a single worker thread operating off an unbounded queue. (Note however that if this single thread terminates due to a failure during execution prior to shutdown, a new one will take its place if needed to execute subsequent tasks.) Tasks are guaranteed to execute sequentially, and no more than one task will be active at any given time. Unlike the otherwise equivalent newFixedThreadPool(1) the returned executor is guaranteed not to be reconfigurable to use additional threads.

只使用一个线程,使用无界队列LinkedBlockingQueue,线程创建后不会超时终止,该线程顺序执行所有任务。该线程池适用于需要确保所有任务被顺序执行的场合。

SingleThreadExecutor适用于需要保证顺序地执行各个任务;并且在任意时间点,不会有多个线程是活动的应用场景。

1

2

3

4

5

|

public static ExecutorService newCachedThreadPool() {

return new ThreadPoolExecutor(0, Integer.MAX_VALUE,

60L, TimeUnit.SECONDS,

new SynchronousQueue<Runnable>());

}

|

Creates a thread pool that creates new threads as needed, but will reuse previously constructed threads when they are available. These pools will typically improve the performance of programs that execute many short-lived asynchronous tasks. Calls to execute will reuse previously constructed threads if available. If no existing thread is available, a new thread will be created and added to the pool. Threads that have not been used for sixty seconds are terminated and removed from the cache. Thus, a pool that remains idle for long enough will not consume any resources. Note that pools with similar properties but different details (for example, timeout parameters) may be created using ThreadPoolExecutor constructors.

它的corePoolSize为0, maximumPoolSize为Integer.MAⅩ_VALUE, keepAliveTime是60秒,队列为SynchronousQueue。它的含义是:当新任务到来时,如果正好有空闲线程在等待任务,则其中一个空闲线程接受该任务,否则就总是创建一个新线程,创建的总线程个数不受限制,对任一空闲线程,如果60秒内没有新任务,就终止。

CachedThreadPool是大小无界的线程池,适用于执行很多的短期异步任务的小程序,或者是负载较轻的服务器。

FutureTask

1

2

3

4

5

6

7

8

9

10

11

|

public class FutureTask<V> implements RunnableFuture<V> {

}

public interface RunnableFuture<V> extends Runnable, Future<V> {

/**

* Sets this Future to the result of its computation

* unless it has been cancelled.

*/

void run();

}

|

CompletableFuture

从Java8开始引入了CompletableFuture,它是Future的功能增强版,可以传入回调对象,当异步任务完成或者发生异常时,自动调用回调对象的回调方法。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

|

public class CompletableFutureDemo3 {

public static void main(String[] args) throws Exception {

CompletableFuture<Integer> completableFuture = CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "-----come in");

int result = ThreadLocalRandom.current().nextInt(10);

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("-----计算结束耗时1秒钟,result: " + result);

if (result > 6) {

int age = 10 / 0;

}

return result;

}).whenComplete((v, e) -> {

if (e == null) {

System.out.println("-----result: " + v);

}

}).exceptionally(e -> {

System.out.println("-----exception: " + e.getCause() + "\t" + e.getMessage());

return -44;

});

//主线程不要立刻结束,否则CompletableFuture默认使用的线程池会立刻关闭:暂停3秒钟线程

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

|

whenComplete:

ForkJoinPool.commonPool-worker-1 —–come in

—–计算结束耗时1秒钟,result: 4

—–result: 4

exceptionally:

ForkJoinPool.commonPool-worker-1 —–come in

—–计算结束耗时1秒钟,result: 9

—–exception: java.lang.ArithmeticException: / by zero java.lang.ArithmeticException: / by zero

CompletableFuture的优点:

异步任务结束时,会自动回调某个对象的方法;

异步任务出错时,会自动回调某个对象的方法;

主线程设置好回调后,不再关心异步任务的执行,异步任务之间可以顺序执行。

案例——电商网站的比价

切记,功能→性能

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

|

public class T1 {

static List<NetMall> list = Arrays.asList(

new NetMall("jd"),

new NetMall("tmall"),

new NetMall("pdd"),

new NetMall("mi")

);

public static List<String> findPriceSync(List<NetMall> list, String productName) {

return list.stream()

.map(mall -> String.format(productName + " %s price is %.2f", mall.getNetMallName(), mall.getPriceByName(productName)))

.collect(Collectors.toList());

}

public static List<String> findPriceASync(List<NetMall> list, String productName) {

return list.stream()

.map(mall -> CompletableFuture.supplyAsync(() -> String.format(productName + " %s price is %.2f", mall.getNetMallName(), mall.getPriceByName(productName))))

.collect(Collectors.toList())

.stream()

.map(CompletableFuture::join)

.collect(Collectors.toList());

}

public static void main(String[] args) {

long startTime = System.currentTimeMillis();

List<String> list1 = findPriceSync(list, "thinking in java");

for (String element : list1) {

System.out.println(element);

}

long endTime = System.currentTimeMillis();

System.out.println("----costTime: " + (endTime - startTime) + " 毫秒");

long startTime2 = System.currentTimeMillis();

List<String> list2 = findPriceASync(list, "thinking in java");

for (String element : list2) {

System.out.println(element);

}

long endTime2 = System.currentTimeMillis();

System.out.println("----costTime: " + (endTime2 - startTime2) + " 毫秒");

}

}

class NetMall {

private String netMallName;

public String getNetMallName() {

return netMallName;

}

public NetMall(String netMallName) {

this.netMallName = netMallName;

}

public double getPriceByName(String productName) {

return calcPrice(productName);

}

private double calcPrice(String productName) {

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

return ThreadLocalRandom.current().nextDouble() + productName.charAt(0);

}

}

|

运行结果:

thinking in java jd price is 116.41

thinking in java tmall price is 116.65

thinking in java pdd price is 116.76

thinking in java mi price is 116.53

—-costTime: 4082 毫秒

thinking in java jd price is 116.42

thinking in java tmall price is 116.28

thinking in java pdd price is 116.06

thinking in java mi price is 116.68

—-costTime: 1008 毫秒

CompletableFuture常用方法

获得结果和触发计算

获得结果:

1

2

3

4

5

|

public T get() throws InterruptedException, ExecutionException {

Object r;

return reportGet((r = result) == null ? waitingGet(true) : r);

}

Waits if necessary for this future to complete, and then returns its result.

|

1

2

3

4

5

6

7

|

public T get(long timeout, TimeUnit unit)

throws InterruptedException, ExecutionException, TimeoutException {

Object r;

long nanos = unit.toNanos(timeout);

return reportGet((r = result) == null ? timedGet(nanos) : r);

}

Waits if necessary for at most the given time for this future to complete, and then returns its result, if available.

|

示例:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

public class CompletableFutureDemo2 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

CompletableFuture<Integer> completableFuture = CompletableFuture.supplyAsync(() -> {

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

return 533;

});

//去掉等待时间上面计算没有完成,返回valueIfAbsent:444

//开启等待时间上面计算完成,返回计算结果533

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(completableFuture.getNow(444));

}

}

|

主动触发计算:

1

2

3

4

5

6

|

public boolean complete(T value) {

boolean triggered = completeValue(value);

postComplete();

return triggered;

}

If not already completed, sets the value returned by get() and related methods to the given value.

|

示例:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

public class CompletableFutureDemo2 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

CompletableFuture<Integer> completableFuture = CompletableFuture.supplyAsync(() -> {

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

return 533;

});

//注释掉暂停时间,get还没有算完只能返回complete方法设置的444;暂停2秒钟,异步线程能够计算完成返回get

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

//当调用CompletableFuture.get()被阻塞的时候,complete方法就是结束阻塞并get()获取设置的complete里面的值.

System.out.println(completableFuture.complete(444) + "\t" + completableFuture.get());

}

}

|

运行结果:

暂停2秒钟,异步线程能够计算完成返回get:

false 533

注释掉暂停时间,get还没有算完只能返回complete方法设置的444:

true 444

对计算结果进行处理

thenApply

存在依赖关系(当前步错,不走下一步),当前步骤有异常的话就叫停。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

|

// 计算结果存在依赖关系,这两个线程串行化

public class CompletableFutureDemo4 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

//当一个线程依赖另一个线程时用 thenApply 方法来把这两个线程串行化,

CompletableFuture.supplyAsync(() -> {

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("111");

return 1024;

}).thenApply(f -> {

System.out.println("222");

return f + 1;

}).thenApply(f -> {

//int age = 10/0; // 异常情况:哪步出错就停在哪步。

System.out.println("333");

return f + 1;

}).whenCompleteAsync((v, e) -> {

System.out.println("*****v: " + v);

}).exceptionally(e -> {

e.printStackTrace();

return null;

});

System.out.println("-----主线程结束,END");

// 主线程不要立刻结束,否则CompletableFuture默认使用的线程池会立刻关闭:

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

|

运行结果:

无异常情况:

—–主线程结束,END

111

222

333

*****v: 1026

有异常情况(int age = 10/0;):

—–主线程结束,END

111

222

*****v: null

java.util.concurrent.CompletionException: java.lang.ArithmeticException: / by zero

at

…

handle

有异常也可以往下一步走,根据带的异常参数可以进一步处理。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

|

public class CompletableFutureDemo4 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

//当一个线程依赖另一个线程时用 handle 方法来把这两个线程串行化,

//异常情况:有异常也可以往下一步走,根据带的异常参数可以进一步处理

CompletableFuture.supplyAsync(() -> {

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("111");

return 1024;

}).handle((f, e) -> {

int age = 10 / 0;

System.out.println("222");

return f + 1;

}).handle((f, e) -> {

System.out.println("333");

return f + 1;

}).whenCompleteAsync((v, e) -> {

System.out.println("*****v: " + v);

}).exceptionally(e -> {

e.printStackTrace();

return null;

});

System.out.println("-----主线程结束,END");

// 主线程不要立刻结束,否则CompletableFuture默认使用的线程池会立刻关闭:

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

|

运行结果:

无异常情况:同上thenApply

有异常情况:

—–主线程结束,END

111

333

*****v: null

java.util.concurrent.CompletionException: java.lang.NullPointerException

…

对计算结果进行消费

1

2

3

4

5

6

7

8

9

10

11

|

public static void main(String[] args) throws ExecutionException, InterruptedException {

CompletableFuture.supplyAsync(() -> {

return 1;

}).thenApply(f -> {

return f + 2;

}).thenApply(f -> {

return f + 3;

}).thenApply(f -> {

return f + 4;

}).thenAccept(r -> System.out.println(r));

}

|

运行结果:10

1

2

3

4

5

6

7

8

9

10

11

|

thenRun

thenRun(Runnable runnable)

// 任务 A 执行完执行 B,并且 B 不需要 A 的结果

thenAccept

thenAccept(Consumer action)

// 任务 A 执行完执行 B,B 需要 A 的结果,但是任务 B 无返回值

thenApply

thenApply(Function fn)

// 任务 A 执行完执行 B,B 需要 A 的结果,同时任务 B 有返回值

|

1

2

3

4

5

6

7

8

|

public static void main(String[] args) {

System.out.println(CompletableFuture.supplyAsync(() -> "resultA")

.thenRun(() -> {}).join());

System.out.println(CompletableFuture.supplyAsync(() -> "resultA")

.thenAccept(resultA -> {}).join());

System.out.println(CompletableFuture.supplyAsync(() -> "resultA")

.thenApply(resultA -> resultA + " resultB").join());

}

|

运行结果:

null

null

resultA resultB

对计算速度进行选用

applyToEither: 谁快用谁

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

public class CompletableFutureDemo5 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

CompletableFuture<Integer> completableFuture1 = CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in ");

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

return 10;

});

CompletableFuture<Integer> completableFuture2 = CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in ");

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

return 20;

});

CompletableFuture<Integer> thenCombineResult = completableFuture1.applyToEither(completableFuture2, f -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in ");

return f + 1;

});

System.out.println(Thread.currentThread().getName() + "\t" + thenCombineResult.get());

}

}

|

运行结果:

ForkJoinPool.commonPool-worker-1 —come in

ForkJoinPool.commonPool-worker-2 —come in

ForkJoinPool.commonPool-worker-2 —come in

main 21

对计算结果进行合并

thenCombine:

两个CompletionStage任务都完成后,最终能把两个任务的结果一起交给thenCombine来处理

先完成的先等着,等待其它分支任务

code标准版:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

public class CompletableFutureDemo2 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

CompletableFuture<Integer> completableFuture1 = CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in ");

return 10;

});

CompletableFuture<Integer> completableFuture2 = CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in ");

return 20;

});

CompletableFuture<Integer> thenCombineResult = completableFuture1.thenCombine(completableFuture2, (x, y) -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in ");

return x + y;

});

System.out.println(thenCombineResult.get());

}

}

|

运行结果:

ForkJoinPool.commonPool-worker-1 —come in

ForkJoinPool.commonPool-worker-1 —come in

main —come in

30

code表达式:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

public class CompletableFutureDemo5 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

CompletableFuture<Integer> thenCombineResult = CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in 1");

return 10;

}).thenCombine(CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in 2");

return 20;

}), (x, y) -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in 3");

return x + y;

}).thenCombine(CompletableFuture.supplyAsync(() -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in 4");

return 30;

}), (a, b) -> {

System.out.println(Thread.currentThread().getName() + "\t" + "---come in 5");

return a + b;

});

System.out.println("-----主线程结束,END");

System.out.println(thenCombineResult.get());

// 主线程不要立刻结束,否则CompletableFuture默认使用的线程池会立刻关闭:

try {

TimeUnit.SECONDS.sleep(10);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

|

运行结果:

ForkJoinPool.commonPool-worker-1 —come in 1

ForkJoinPool.commonPool-worker-1 —come in 2

main —come in 3

ForkJoinPool.commonPool-worker-2 —come in 4

main —come in 5

—–主线程结束,END

60

锁

synchronized

-

修饰实例方法,作用于当前实例,进入同步代码前需要先获取实例的锁

synchronized实例方法实际保护的是同一个对象的方法调用,确保同时只能有一个线程执行。再具体来说,synchronized实例方法保护的是当前实例对象,即this。this对象有一个锁和一个等待队列,锁只能被一个线程持有,其他试图获得同样锁的线程需要等待。

一般在保护变量时,需要在所有访问该变量的方法上加上synchronized。

-

修饰静态方法,作用于类的Class对象,进入修饰的静态方法前需要先获取类的Class对象的锁

-

修饰代码块,需要指定加锁对象(记做lockobj),在进入同步代码块前需要先获取lockobj的锁

可重入性

每个锁对象拥有一个锁计数器和一个指向持有该锁的线程的指针。

当执行monitorenter时,如果目标锁对象的计数器为零,那么说明它没有被其他线程所持有,Java虚拟机会将该锁对象的持有线程设置为当前线程,并且将其计数器加1。

在目标锁对象的计数器不为零的情况下,如果锁对象的持有线程是当前线程,那么 Java 虚拟机可以将其计数器加1,否则需要等待,直至持有线程释放该锁。

当执行monitorexit时,Java虚拟机则需将锁对象的计数器减1。计数器为零代表锁已被释放。

内存可见性

synchronized除了保证原子操作外,它还有一个重要的作用,就是保证内存可见性,在释放锁时,所有写入都会写回内存,而获得锁后,都会从内存中读最新数据。

不过,如果只是为了保证内存可见性,使用synchronized的成本有点高,有一个更轻量级的方式,那就是给变量加修饰符volatile。

加了volatile之后,Java会在操作对应变量时插入特殊的指令,保证读写到内存最新值,而非缓存的值。

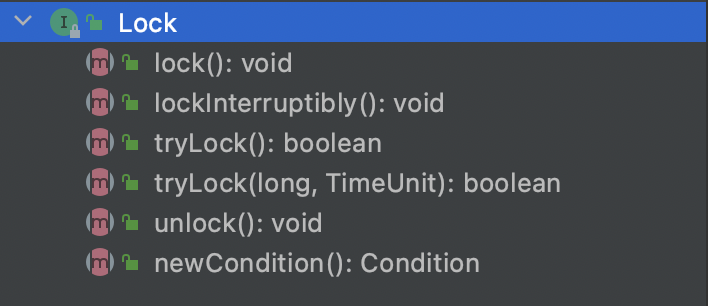

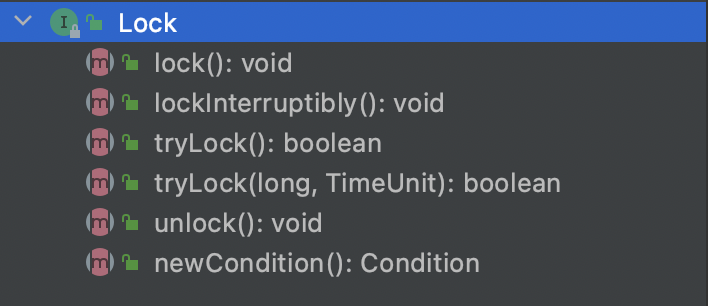

Lock

1

2

3

4

5

6

|

Lock lock = new ReentrantLock();

lock.lock();

try {

} finally {

lock.unlock();

}

|

在finally块中释放锁,目的是保证在获取到锁之后,最终能够被释放。

不要将获取锁的过程写在try块中,因为如果在获取锁(自定义锁的实现)时发生了异常,异常抛出的同时,也会导致锁无故释放。

1)lock()/unlock():就是普通的获取锁和释放锁方法,lock()会阻塞直到成功。

2)lockInterruptibly():与lock()的不同是,它可以响应中断,如果被其他线程中断了,则抛出InterruptedException。

3)tryLock():只是尝试获取锁,立即返回,不阻塞,如果获取成功,返回true,否则返回false。

4)tryLock(long time, TimeUnit unit):先尝试获取锁,如果能成功则立即返回true,否则阻塞等待,但等待的最长时间由指定的参数设置,在等待的同时响应中断。如果发生了中断,抛出InterruptedException,如果在等待的时间内获得了锁,返回true,否则返回false。

5)newCondition:新建一个条件,一个Lock可以关联多个条件。

synchronized VS Lock

- synchronized是Java内置关键字,在JVM层面,Lock是个Java类;

- synchronized无法判断是否获取锁的状态,Lock可以判断是否获取到锁;

- synchronized会自动释放锁(a 线程执行完同步代码会释放锁 ;b 线程执行过程中发生异常会释放锁),Lock需在finally中手工释放锁(unlock()方法释放锁),否则容易造成线程死锁;

- 用synchronized关键字的两个线程1和线程2,如果当前线程1获得锁,线程2线程等待。如果线程1阻塞,线程2则会一直等待下去,而Lock锁就不一定会等待下去,如果尝试获取不到锁,线程可以不用一直等待就结束了;

- synchronized的锁可重入、不可中断、非公平,而Lock锁可重入、可中断、可公平(两者皆可)

- synchronized锁适合代码少量的同步问题,Lock锁适合大量同步代码的同步问题,。

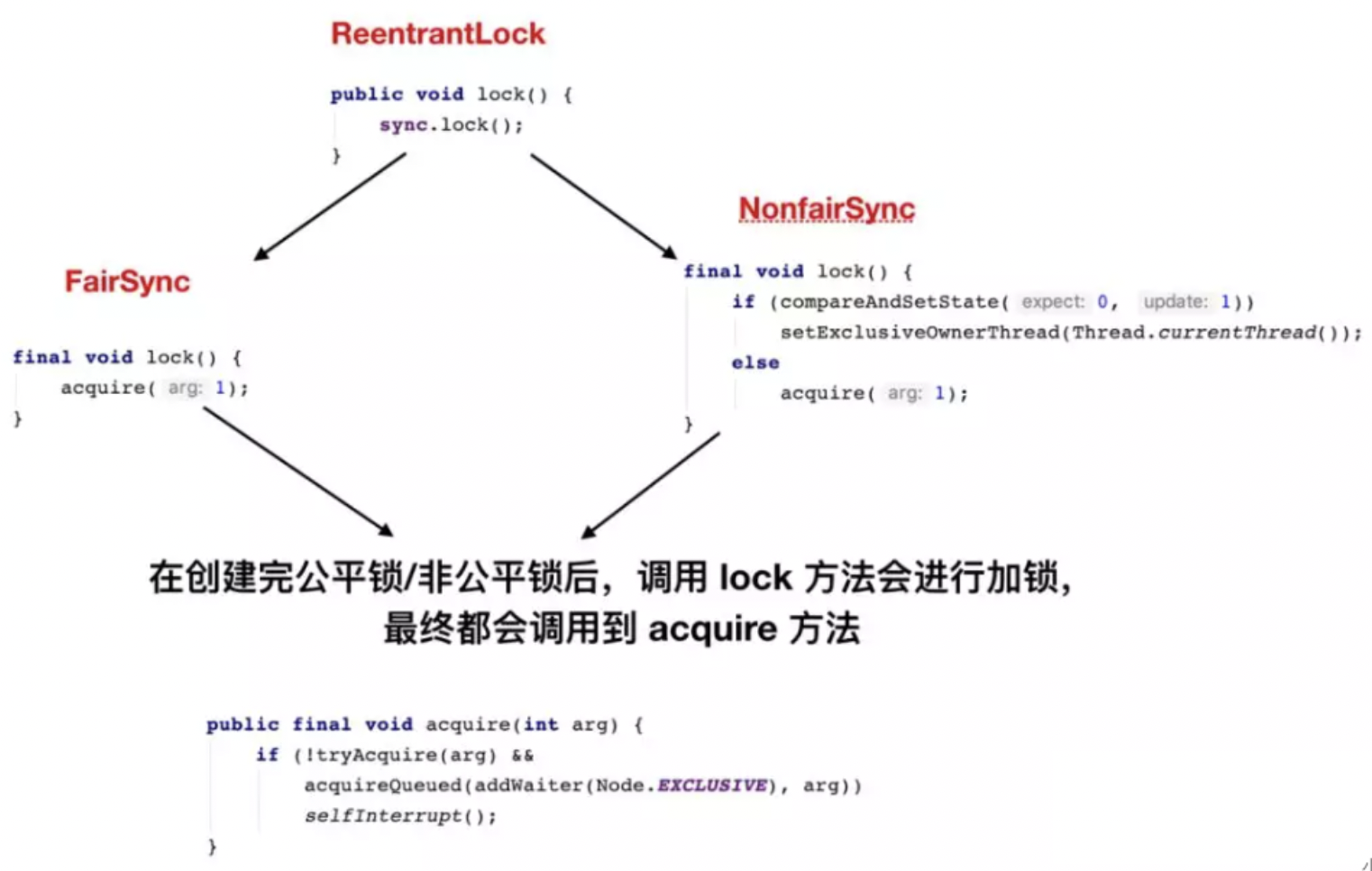

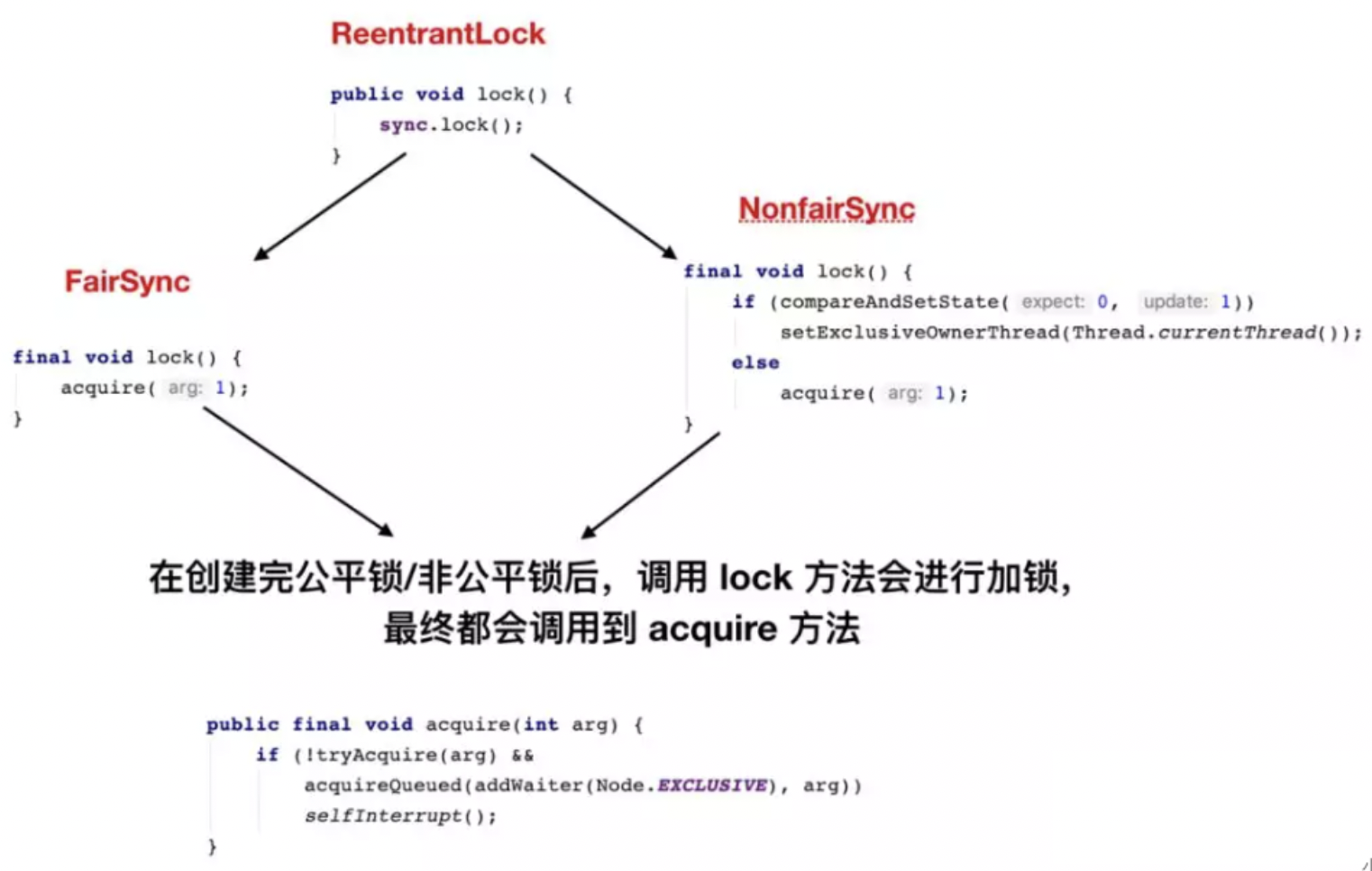

ReentrantLock

ReentrantLock是Lock的默认实现:

-

可重入锁:可重入锁是指同一个线程可以多次获得同一把锁;ReentrantLock和关键字Synchronized都是可重入锁

-

可中断锁:可中断锁时子线程在获取锁的过程中,是否可以相应线程中断操作。synchronized是不可中断的,ReentrantLock是可中断的

-

公平锁和非公平锁:公平锁是指多个线程尝试获取同一把锁的时候,获取锁的顺序按照线程到达的先后顺序获取,而不是随机插队的方式获取。synchronized是非公平锁,而ReentrantLock是两种都可以实现,不过默认是非公平锁

在测试中公平性锁与非公平性锁相比,总耗时是其94.3倍,总切换次数是其133倍。可以看出,公平性锁保证了锁的获取按照FIFO原则,而代价是进行大量的线程切换。非公平性锁虽然可能造成线程“饥饿”,但极少的线程切换,保证了其更大的吞吐量。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

/**

* Creates an instance of {@code ReentrantLock}.

* This is equivalent to using {@code ReentrantLock(false)}.

*/

public ReentrantLock() {

sync = new NonfairSync();

}

/**

* Creates an instance of {@code ReentrantLock} with the

* given fairness policy.

*

* @param fair {@code true} if this lock should use a fair ordering policy

*/

public ReentrantLock(boolean fair) {

sync = fair ? new FairSync() : new NonfairSync();

}

|

ReentrantLock获取锁的过程是可中断的

对于synchronized关键字,如果一个线程在等待获取锁,最终只有2种结果:

- 要么获取到锁然后继续后面的操作

- 要么一直等待,直到其他线程释放锁为止

而ReentrantLock提供了另外一种可能,就是在等待获取锁的过程中(发起获取锁请求到还未获取到锁这段时间内)是可以被中断的,也就是说在等待锁的过程中,程序可以根据需要取消获取锁的请求。有些使用这个操作是非常有必要的。

关于获取锁的过程中被中断,注意几点:

- ReentrankLock中必须使用实例方法

lockInterruptibly()获取锁时,在线程调用interrupt()方法之后,才会引发InterruptedException异常

- 线程调用interrupt()之后,线程的中断标志会被置为true

- 触发InterruptedException异常之后,线程的中断标志会被清空,即置为false

- 所以当线程调用interrupt()引发InterruptedException异常,中断标志的变化是:false->true->false

synchronized VS ReentrantLock

相比synchronized, ReentrantLock可以实现与synchronized相同的语义,而且支持以非阻塞方式获取锁,可以响应中断,可以限时,更为灵活。不过,synchronized的使用更为简单,写的代码更少,也更不容易出错。

- synchronized代表一种声明式编程思维,程序员更多的是表达一种同步声明,由Java系统负责具体实现,程序员不知道其实现细节;

- 显式锁代表一种命令式编程思维,程序员实现所有细节。

声明式编程的好处除了简单,还在于性能,在较新版本的JVM上,ReentrantLock和synchronized的性能是接近的,但Java编译器和虚拟机可以不断优化synchronized的实现,比如自动分析synchronized的使用,对于没有锁竞争的场景,自动省略对锁获取/释放的调用。

简单总结下,能用synchronized就用synchronized,不满足要求时再考虑ReentrantLock。

悲观锁

认为自己在使用数据的时候一定有别的线程来修改数据,因此在获取数据的时候会先加锁,确保数据不会被别的线程修改。

synchronized关键字和Lock的实现类都是悲观锁

适合写操作多的场景,先加锁可以保证写操作时数据正确。

显式的锁定之后再操作同步资源

乐观锁

乐观锁认为自己在使用数据时不会有别的线程修改数据,所以不会添加锁,只是在更新数据的时候去判断之前有没有别的线程更新了这个数据。

如果这个数据没有被更新,当前线程将自己修改的数据成功写入。如果数据已经被其他线程更新,则根据不同的实现方式执行不同的操作

乐观锁在Java中是通过使用无锁编程来实现,最常采用的是CAS算法,Java原子类中的递增操作就通过CAS自旋实现的。

适合读操作多的场景,不加锁的特点能够使其读操作的性能大幅提升。

乐观锁则直接去操作同步资源,是一种无锁算法。

乐观锁一般有两种实现方式:

- 采用版本号机制

- CAS(Compare-and-Swap,即比较并替换)算法实现

可重入锁(又名递归锁)

是指在同一个线程在外层方法获取锁的时候,再进入该线程的内层方法会自动获取锁(前提,锁对象得是同一个对象),不会因为之前已经获取过还没释放而阻塞。

如果是1个有 synchronized 修饰的递归调用方法,程序第2次进入被自己阻塞了岂不是天大的笑话,出现了作茧自缚。所以Java中ReentrantLock和synchronized都是可重入锁,可重入锁的一个优点是可一定程度避免死锁。

排查死锁

线程中断

首先 一个线程不应该由其他线程来强制中断或停止,而是应该由线程自己自行停止。所以,Thread.stop, Thread.suspend, Thread.resume 都已经被废弃了。

其次 在Java中没有办法立即停止一条线程,然而停止线程却显得尤为重要,如取消一个耗时操作。因此,Java提供了一种用于停止线程的机制——中断。

中断只是一种协作机制,Java没有给中断增加任何语法,中断的过程完全需要程序员自己实现。若要中断一个线程,你需要手动调用该线程的interrupt方法,该方法也仅仅是将线程对象的中断标识设成true;接着你需要自己写代码不断地检测当前线程的标识位,如果为true,表示别的线程要求这条线程中断, 此时究竟该做什么需要你自己写代码实现。

每个线程对象中都有一个标识,用于表示线程是否被中断;该标识位为true表示中断,为false表示未中断;通过调用线程对象的interrupt方法将该线程的标识位设为true;可以在别的线程中调用,也可以在自己的线程中调用。

如何使用中断标识停止线程?

在需要中断的线程中不断监听中断状态,一旦发生中断,就执行相应的中断处理业务逻辑。

1、通过一个volatile变量

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

public class InterruptDemo {

private static volatile boolean isStop = false;

public static void main(String[] args) {

new Thread(() -> {

while (true) {

if (isStop) {

System.out.println(Thread.currentThread().getName() + "线程------isStop = true,自己退出了");

break;

}

System.out.println("-------hello interrupt");

}

}, "t1").start();

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

isStop = true;

}

}

|

运行结果:

——-hello interrupt

——-hello interrupt

——-hello interrupt

——-hello interrupt

…

——-hello interrupt

——-hello interrupt

——-hello interrupt

t1线程——isStop = true,自己退出了

2、通过AtomicBoolean

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

public class StopThreadDemo {

private final static AtomicBoolean atomicBoolean = new AtomicBoolean(true);

public static void main(String[] args) {

Thread t1 = new Thread(() -> {

while (atomicBoolean.get()) {

try {

TimeUnit.MILLISECONDS.sleep(500);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("-----hello");

}

}, "t1");

t1.start();

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

atomicBoolean.set(false);

}

}

|

—–hello

—–hello

—–hello

—–hello

—–hello

—–hello

3、通过Thread类自带的中断api方法

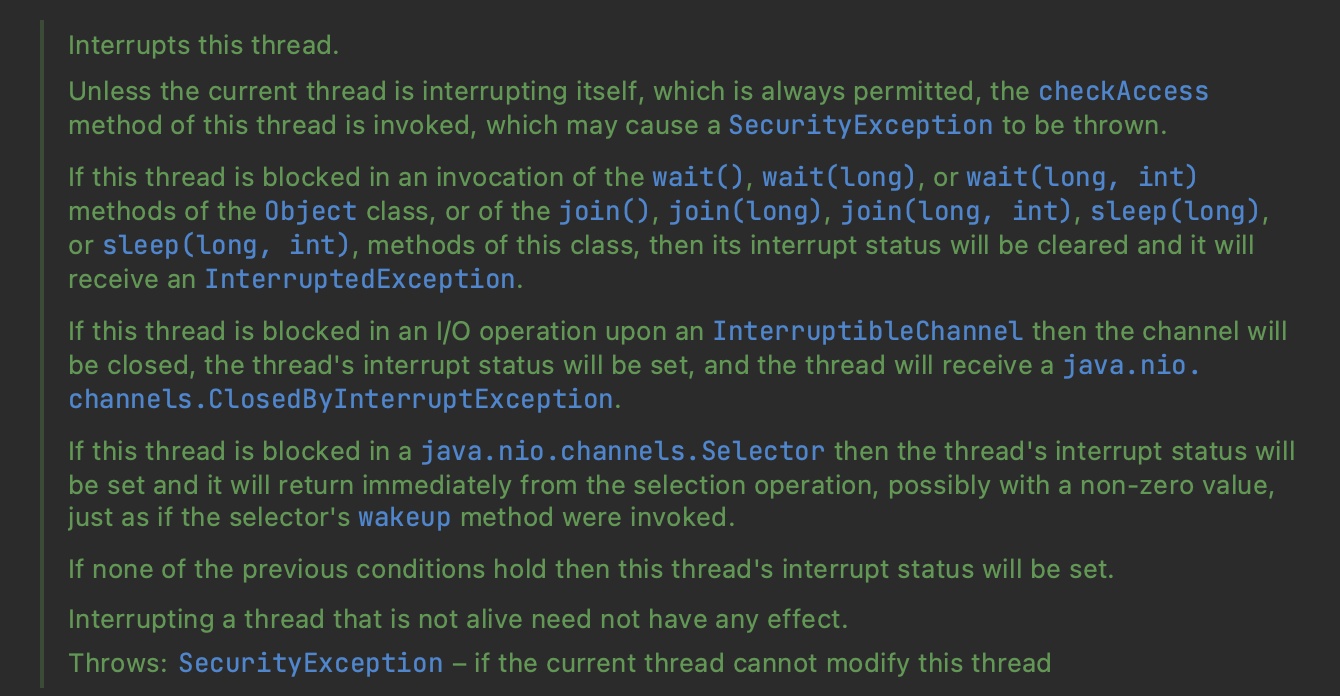

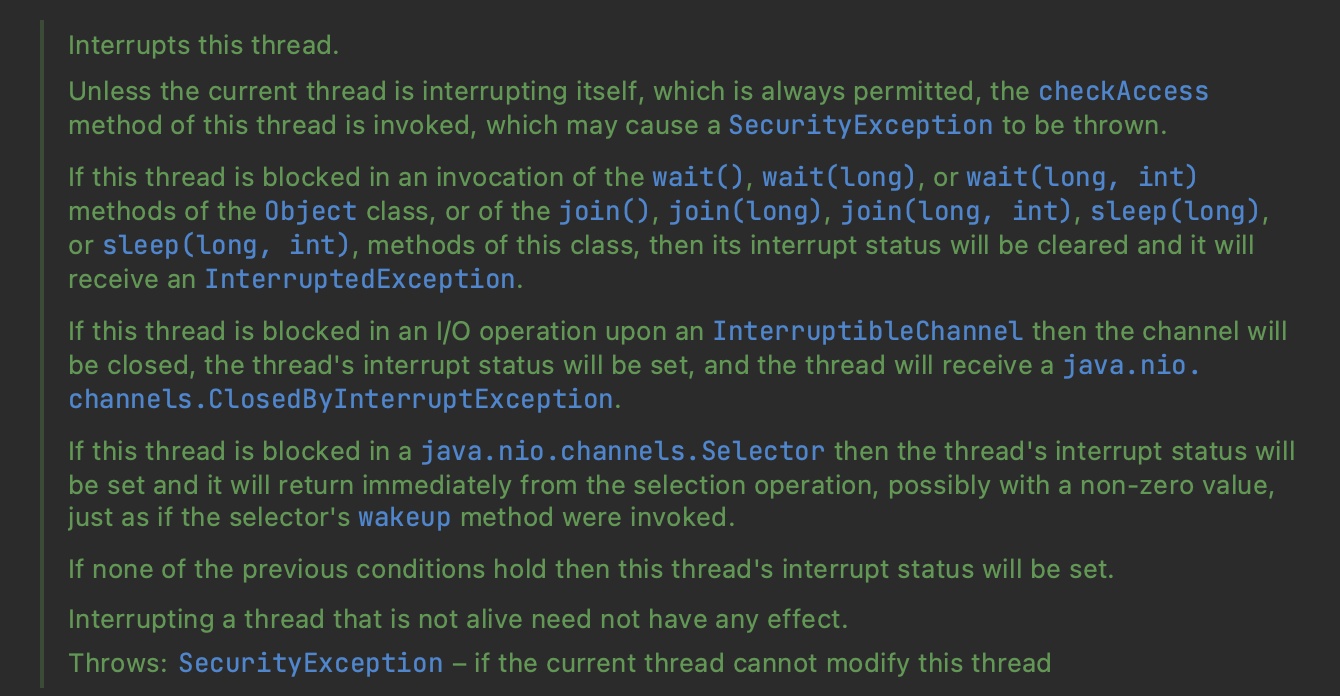

(1)、实例方法interrupt(),没有返回值

调用interrupt()方法仅仅是在当前线程中打了一个停止的标记,并不是真正立刻停止线程。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

public void interrupt() {

if (this != Thread.currentThread())

checkAccess();

synchronized (blockerLock) {

Interruptible b = blocker;

if (b != null) {

interrupt0(); // Just to set the interrupt flag

b.interrupt(this);

return;

}

}

interrupt0();

}

|

(2)、实例方法isInterrupted,返回布尔值

获取中断标志位的当前值是什么

判断当前线程是否被中断(通过检查中断标志位),默认是false

(3)、静态方法Thread.interrupted()

判断线程是否被中断,并清除当前中断状态,类似i++

这个方法做了两件事:

- 返回当前线程的中断状态

- 将当前线程的中断状态设为false

示例:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

/**

* 测试当前线程是否被中断(检查中断标志),返回一个boolean并清除中断状态,

* 第二次再调用时中断状态已经被清除,将返回一个false。

*/

public class InterruptDemo {

public static void main(String[] args) throws InterruptedException {

System.out.println(Thread.currentThread().getName() + "---" + Thread.interrupted());

System.out.println(Thread.currentThread().getName() + "---" + Thread.interrupted());

System.out.println("111111");

Thread.currentThread().interrupt();

System.out.println("222222");

System.out.println(Thread.currentThread().getName() + "---" + Thread.interrupted());

System.out.println(Thread.currentThread().getName() + "---" + Thread.interrupted());

}

}

|

运行结果:

main—false

main—false

111111

222222

main—true

main—false

当前线程的中断标识为true,是不是就立刻停止?

具体来说,当对一个线程,调用 interrupt() 时:

① 如果线程处于正常活动状态,那么会将该线程的中断标志设置为 true,仅此而已。 被设置中断标志的线程将继续正常运行,不受影响。所以, interrupt() 并不能真正的中断线程,需要被调用的线程自己进行配合才行。

② 如果线程处于被阻塞状态(例如处于sleep, wait, join 等状态),在别的线程中调用当前线程对象的interrupt方法, 那么线程将立即退出被阻塞状态,并抛出一个InterruptedException异常。

LockSupport

0、3种让线程等待和唤醒的方法

- Object中的wait()方法让线程等待,notify()方法唤醒线程

- JUC包中Condition的await()方法让线程等待,signal()方法唤醒线程

- LockSupport类中的park()阻塞线程,unpark()解除阻塞线程

1、Object类中的wait和notify方法

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

public class LockSupportDemo {

public static void main(String[] args) {

Object objectLock = new Object();

new Thread(() -> {

synchronized (objectLock) {

System.out.println(Thread.currentThread().getName() + "\t ---come in");

try {

objectLock.wait();//----------------------这里先让他等待

} catch (InterruptedException e) {

e.printStackTrace();

}

}

System.out.println(Thread.currentThread().getName() + "\t ---被唤醒了");

}, "t1").start();

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(3L);

} catch (InterruptedException e) {

e.printStackTrace();

}

new Thread(() -> {

synchronized (objectLock) {

objectLock.notify();//-------------------------再唤醒它

System.out.println(Thread.currentThread().getName() + "\t ---发出通知");

}

}, "t2").start();

}

}

|

t1 —come in

t2 —发出通知

t1 —被唤醒了

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

public class LockSupportDemo {

public static void main(String[] args) {

Object objectLock = new Object();

new Thread(() -> {

// synchronized (objectLock) {

System.out.println(Thread.currentThread().getName() + "\t ---come in");

try {

objectLock.wait();//----------------------这里先让他等待

} catch (InterruptedException e) {

e.printStackTrace();

}

// }

System.out.println(Thread.currentThread().getName() + "\t ---被唤醒了");

}, "t1").start();

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(3L);

} catch (InterruptedException e) {

e.printStackTrace();

}

new Thread(() -> {

// synchronized (objectLock) {

objectLock.notify();//-------------------------再唤醒它

System.out.println(Thread.currentThread().getName() + "\t ---发出通知");

// }

}, "t2").start();

}

}

|

t1 —come in

Exception in thread “t1” java.lang.IllegalMonitorStateException

at java.lang.Object.wait(Native Method)

…

Exception in thread “t2” java.lang.IllegalMonitorStateException

at java.lang.Object.notify(Native Method)

…

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

public class LockSupportDemo {

public static void main(String[] args) {

Object objectLock = new Object();

new Thread(() -> {

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(3L);

} catch (InterruptedException e) {

e.printStackTrace();

}

synchronized (objectLock) {

System.out.println(Thread.currentThread().getName() + "\t ---come in");

try {

objectLock.wait();//----------------------这里先让他等待

} catch (InterruptedException e) {

e.printStackTrace();

}

}

System.out.println(Thread.currentThread().getName() + "\t ---被唤醒了");

}, "t1").start();

new Thread(() -> {

synchronized (objectLock) {

objectLock.notify();//-------------------------再唤醒它

System.out.println(Thread.currentThread().getName() + "\t ---发出通知");

}

}, "t2").start();

}

}

|

一直处于运行中,无法停止:

t2 —发出通知

t1 —come in

总结:

Object中的wait和notify方法必须

- 要在同步块或者方法里面

- 先wait后notify的顺序成对使用

2、Condition接口中的await和signal方法

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

|

public class LockSupportDemo {

public static void main(String[] args) {

Lock lock = new ReentrantLock();

Condition condition = lock.newCondition();

new Thread(() -> {

lock.lock();

try {

System.out.println(Thread.currentThread().getName() + "\t -----come in");

condition.await();

System.out.println(Thread.currentThread().getName() + "\t -----被唤醒");

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}, "t1").start();

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

new Thread(() -> {

lock.lock();

try {

condition.signal();

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

}

System.out.println(Thread.currentThread().getName() + "\t" + "我要进行唤醒");

}, "t2").start();

}

}

|

t1 —–come in

t2 我要进行唤醒

t1 —–被唤醒

- 异常1原理同上

- 仍然返回

IllegalMonitorStateException

- 异常2原理同上

总结:

Condtion中的await和notify方法必须

Object和Condition使用的限制条件:

- 线程先要获得并持有锁,必须在锁块(synchronized或lock)中

- 必须要先等待后唤醒,线程才能够被唤醒

3、LockSupport类中的park等待和unpark唤醒

通过park()和unpark(thread)方法来实现阻塞和唤醒线程

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

public class LockSupportDemo {

public static void main(String[] args) {

Thread t1 = new Thread(() -> {

System.out.println(Thread.currentThread().getName() + "\t----------come in");

LockSupport.park();

System.out.println(Thread.currentThread().getName() + "\t----------被唤醒了");

}, "t1");

t1.start();

new Thread(() -> {

LockSupport.unpark(t1);

System.out.println(Thread.currentThread().getName() + "\t-----发出通知,去唤醒t1");

}, "t2").start();

}

}

|

t1 ———-come in

t2 —–发出通知,去唤醒t1

t1 ———-被唤醒了

- 之前错误的先唤醒后等待,LockSupport照样支持

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

public class LockSupportDemo {

public static void main(String[] args) {

Thread t1 = new Thread(() -> {

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(Thread.currentThread().getName() + "\t----------come in" + "\t" + System.currentTimeMillis());

LockSupport.park();

System.out.println(Thread.currentThread().getName() + "\t----------被唤醒了" + "\t" + System.currentTimeMillis());

}, "t1");

t1.start();

new Thread(() -> {

LockSupport.unpark(t1);

System.out.println(Thread.currentThread().getName() + "\t-----发出通知,去唤醒t1");

}, "t2").start();

}

}

|

t2 —–发出通知,去唤醒t1

t1 ———-come in 1660201673319

t1 ———-被唤醒了 1660201673319

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

public class LockSupportDemo {

public static void main(String[] args) {

Thread t1 = new Thread(() -> {

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(Thread.currentThread().getName() + "\t----------come in" + "\t" + System.currentTimeMillis());

LockSupport.park();

LockSupport.park();

System.out.println(Thread.currentThread().getName() + "\t----------被唤醒了" + "\t" + System.currentTimeMillis());

}, "t1");

t1.start();

new Thread(() -> {

LockSupport.unpark(t1);

LockSupport.unpark(t1);

System.out.println(Thread.currentThread().getName() + "\t-----发出通知,去唤醒t1");

}, "t2").start();

}

}

|

t2 —–发出通知,去唤醒t1

t1 ———-come in 1654750970677——————–卡在这里了

Lock Support和每个使用它的线程都有一个许可(permit) 关联。

每个线程都有一个相关的permit, permit最多只有一个, 重复调用unpark也不会积累凭证。

4、总结:

LockSupport是用来创建锁和其他同步类的基本线程阻塞原语。

LockSupport类使用了一种名为Permit(许可) 的概念来做到阻塞和唤醒线程, 每个线程都有一个许可(permit)。

permit(许可)只有两个值1和0,默认是0,0 是阻塞,1是唤醒。

可以把许可看成是一种(0,1)信号量(Semaphore),但与 Semaphore 不同的是,许可的累加上限是1。

JMM

Java虚拟机规范中试图定义一种Java内存模型(java Memory Model,简称JMM) 来屏蔽掉各种硬件和操作系统的内存访问差异,以实现让Java程序在各种平台下都能达到一致的内存访问效果。

Java中普通的共享变量不保证可见性,因为数据修改被写入内存的时机是不确定的,多线程并发下很可能出现"脏读",所以每个线程都有自己的工作内存,线程自己的工作内存中保存了该线程使用到的变量的主内存副本拷贝,线程对变量的所有操作(读取,赋值等 )都必需在线程自己的工作内存中进行,而不能够直接读写主内存中的变量。不同线程之间也无法直接访问对方工作内存中的变量,线程间变量值的传递均需要通过主内存来完成。

happens-before规则

JMM规范下,多线程先行发生原则之happens-before:

在JMM中,如果一个操作执行的结果需要对另一个操作可见性或者代码重排序,那么这两个操作之间必须存在happens-before关系。

JSR-133使用happens-before的概念来指定两个操作之间的执行顺序。由于这两个操作可以在一个线程之内,也可以是在不同线程之间。因此,JMM可以通过happens-before关系向程序员提供跨线程的内存可见性保证(如果A线程的写操作a与B线程的读操作b之间存在happens-before关系,尽管a操作和b操作在不同的线程中执行,但JMM向程序员保证a操作将对b操作可见)

《JSR-133:Java Memory Model and Thread Specification》定义了如下happens-before规则。

1)程序顺序规则:一个线程中的每个操作,happens-before于该线程中的任意后续操作。

2)监视器锁规则:对一个锁的解锁,happens-before于随后对这个锁的加锁。

3)volatile变量规则:对一个volatile域的写,happens-before于任意后续对这个volatile域的读。

4)传递性:如果A happens-before B,且B happens-before C,那么A happens-before C。

5)start()规则:如果线程A执行操作ThreadB.start()(启动线程B),那么A线程的ThreadB.start()操作happens-before于线程B中的任意操作。

6)join()规则:如果线程A执行操作ThreadB.join()并成功返回,那么线程B中的任意操作happens-before于线程A从ThreadB.join()操作成功返回。

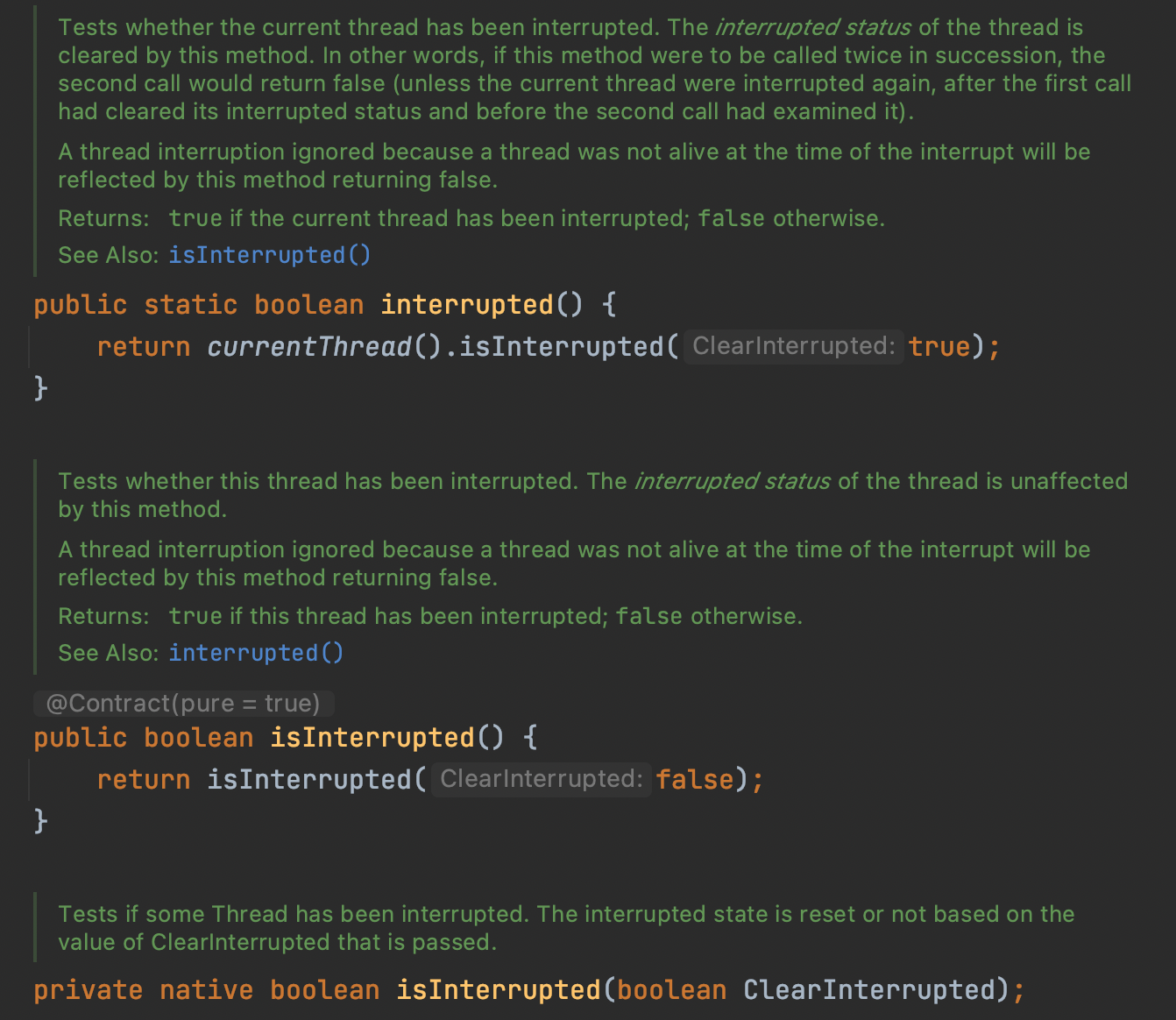

volatile

被volatile修改的变量有2大特点:

volatile的内存语义:

- 当写一个volatile变量时,JMM会把该线程对应的本地内存中的共享变量值立即刷新回主内存中。

- 当读一个volatile变量时,JMM会把该线程对应的本地内存设置为无效,直接从主内存中读取共享变量

- 所以volatile的写内存语义是直接刷新到主内存中,读内存语义是直接从主内存中读取。

内存屏障 (Memory Barriers / Fences)

内存屏障(也称内存栅栏,内存栅障,屏障指令等,是一类同步屏障指令,是CPU或编译器在对内存随机访问的操作中的一个同步点,使得此点之前的所有读写操作都执行后才可以开始执行此点之后的操作),避免代码重排序。

内存屏障其实就是一种JVM指令,Java内存模型的重排规则会要求Java编译器在生成JVM指令时插入特定的内存屏障指令,通过这些内存屏障指令,volatile实现了Java内存模型中的可见性和有序性,但volatile无法保证原子性。

内存屏障之前的所有写操作都要回写到主内存,内存屏障之后的所有读操作都能获得内存屏障之前的所有写操作的最新结果(实现了可见性)。

因此重排序时,不允许把内存屏障之后的指令重排序到内存屏障之前。 一句话:对一个 volatile 域的写, happens-before 于任意后续对这个 volatile 域的读,也叫写后读。

happens-before 之 volatile 变量规则

当第一个操作为volatile读时,不论第二个操作是什么,都不能重排序。这个操作保证了volatile读之后的操作不会被重排到volatile读之前。

当第二个操作为volatile写时,不论第一个操作是什么,都不能重排序。这个操作保证了volatile写之前的操作不会被重排到volatile写之后。

当第一个操作为volatile写时,第二个操作为volatile读时,不能重排。

JMM 就将内存屏障插⼊策略分为 4 种

- 读

- 在每个 volatile 读操作的后⾯插⼊⼀个 LoadLoad 屏障

- 在每个 volatile 读操作的后⾯插⼊⼀个 LoadStore 屏障

- 写

- 在每个 volatile 写操作的前⾯插⼊⼀个 StoreStore 屏障

- 在每个 volatile 写操作的后⾯插⼊⼀个 StoreLoad 屏障

volatile特性

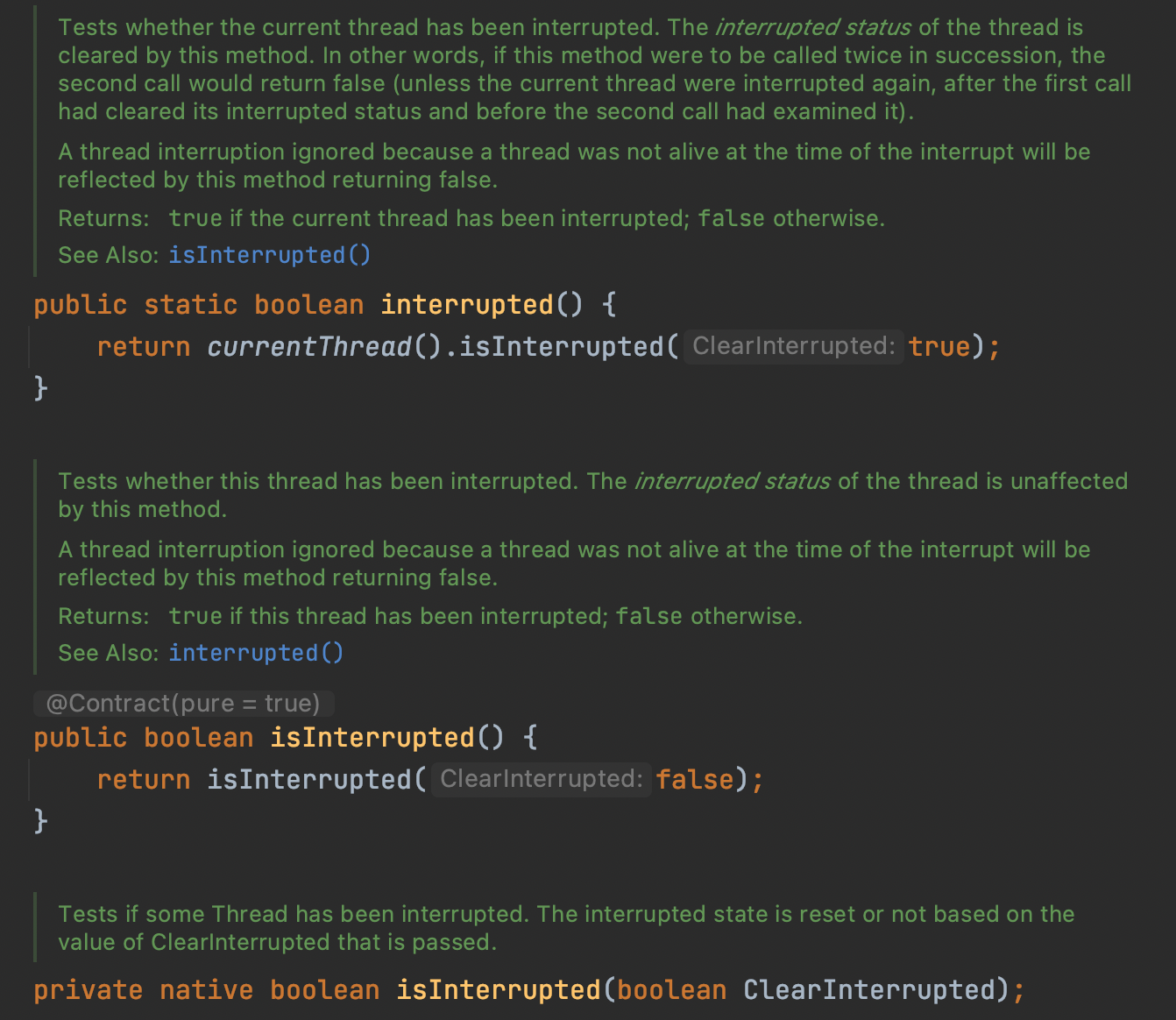

1、保证可见性

保证不同线程对这个变量进行操作时的可见性,即变量一旦改变所有线程立即可见

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

public class VolatileSeeDemo {

static boolean flag = true; //不加volatile,没有可见性

//static volatile boolean flag = true; //加了volatile,保证可见性

public static void main(String[] args) {

new Thread(() -> {

System.out.println(Thread.currentThread().getName() + "\t come in");

while (flag) {

}

System.out.println(Thread.currentThread().getName() + "\t flag被修改为false,退出.....");

}, "t1").start();

//暂停2秒钟后让main线程修改flag值

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

flag = false;

System.out.println("main线程修改完成");

}

}

|

t1 come in

main线程修改完成

//卡住了

t1 come in

main线程修改完成

t1 flag被修改为false,退出…..

线程t1中为何看不到被主线程main修改为false的flag的值?

问题可能:

- 主线程修改了flag之后没有将其刷新到主内存,所以t1线程看不到。

- 主线程将flag刷新到了主内存,但是t1一直读取的是自己工作内存中flag的值,没有去主内存中更新获取flag最新的值。

诉求:

1.线程中修改了工作内存中的副本之后,立即将其刷新到主内存;

2.工作内存中每次读取共享变量时,都去主内存中重新读取,然后拷贝到工作内存。

解决:

使用volatile修饰共享变量,就可以达到上面的效果,被volatile修改的变量有以下特点:

- 线程中读取的时候,每次读取都会去主内存中读取共享变量最新的值,然后将其复制到工作内存

- 线程中修改了工作内存中变量的副本,修改之后会立即刷新到主内存

volatile变量的读写过程

Java内存模型中定义的8种工作内存与主内存之间的原子操作

read(读取)→load(加载)→use(使用)→assign(赋值)→store(存储)→write(写入)→lock(锁定)→unlock(解锁)

2、没有原子性

volatile变量的复合操作(如i++)不具有原子性

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

public class VolatileNoAtomicDemo {

public static void main(String[] args) throws InterruptedException {

MyNumber myNumber = new MyNumber();

for (int i = 1; i <= 10; i++) {

new Thread(() -> {

for (int j = 1; j <= 1000; j++) {

myNumber.addPlusPlus();

}

}, String.valueOf(i)).start();

}

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(3);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(Thread.currentThread().getName() + "\t" + myNumber.number);

}

}

|

运行结果一般都不是10000:

main 9733

原子性指的是一个操作是不可中断的,即使是在多线程环境下,一个操作一旦开始就不会被其他线程影响。

public void add()

{

i++;

//不具备原子性,该操作是先读取值,然后写回一个新值,相当于原来的值加上1,分3步完成

}

如果第二个线程在第一个线程读取旧值和写回新值期间读取i的域值,那么第二个线程就会与第一个线程一起看到同一个值,并执行相同值的加1操作,这也就造成了线程安全失败,因此对于add方法必须使用synchronized修饰,以便保证线程安全。

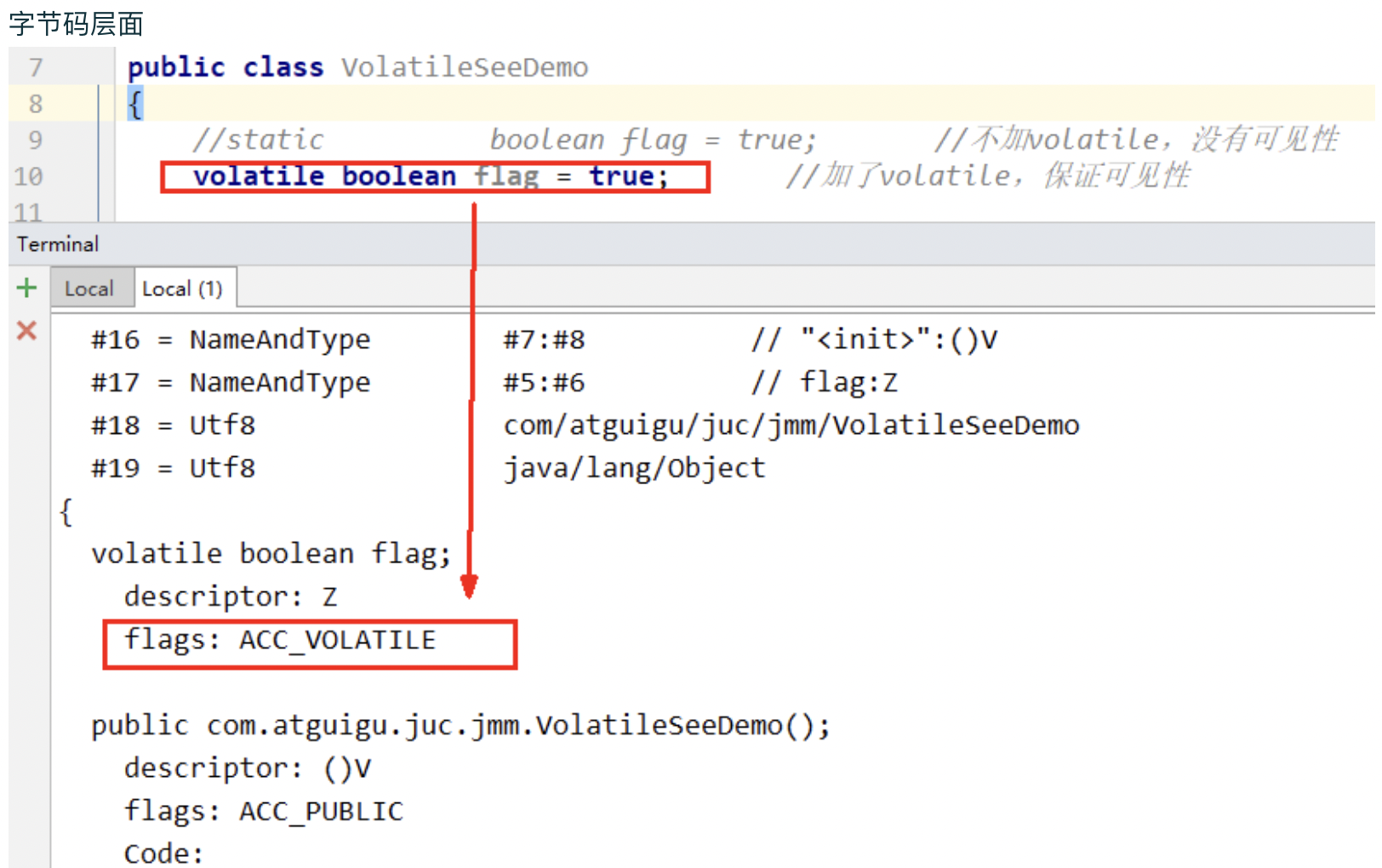

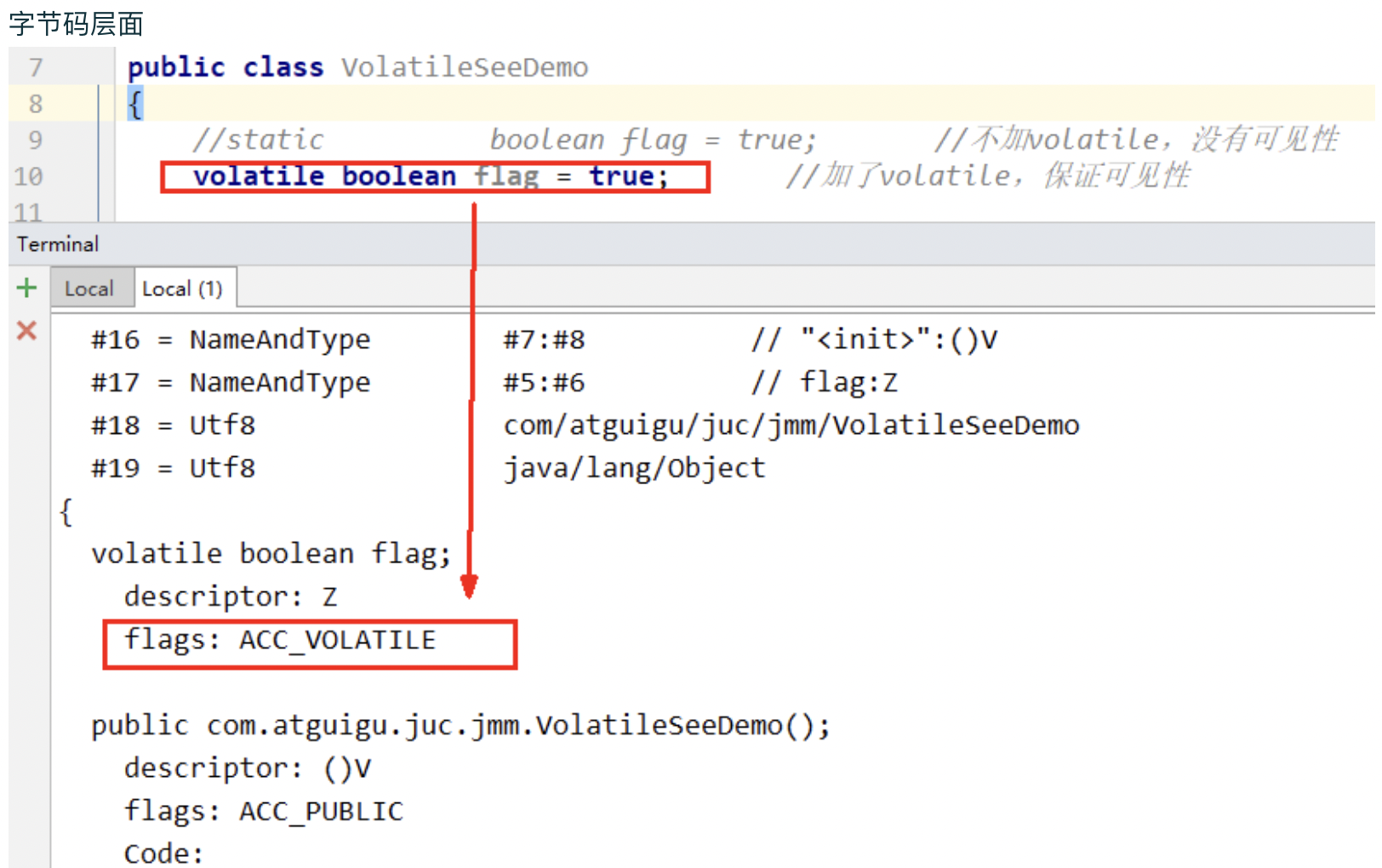

3、指令禁重排

重排序:重排序是指编译器和处理器为了优化程序性能而对指令序列进行重新排序的一种手段,有时候会改变程序语句的先后顺序

不存在数据依赖关系,可以重排序;存在数据依赖关系,禁止重排序。

但重排后的指令绝对不能改变原有的串行语义!这点在并发设计中必须要重点考虑!

volatile的底层实现是通过内存屏障

当第一个操作为volatile读时,不论第二个操作是什么,都不能重排序。这个操作保证了volatile读之后的操作不会被重排到volatile读之前。

当第二个操作为volatile写时,不论第一个操作是什么,都不能重排序。这个操作保证了volatile写之前的操作不会被重排到volatile写之后。

当第一个操作为volatile写时,第二个操作为volatile读时,不能重排。

为什么Java写了一个volatile关键字系统底层加入内存屏障?

volatile应用

1、单一赋值可以,但是含复合运算赋值不可以(i++之类)

1

2

|

volatile int a = 10

volatile boolean flag = false

|

2、状态标志,判断业务是否结束

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

/**

* 使用:作为一个布尔状态标志,用于指示发生了一个重要的一次性事件,例如完成初始化或任务结束

* 理由:状态标志并不依赖于程序内任何其他状态,且通常只有一种状态转换

* 例子:判断业务是否结束

*/

public class UseVolatileDemo {

private volatile static boolean flag = true;

public static void main(String[] args) {

new Thread(() -> {

while (flag) {

//do something......

}

}, "t1").start();

//暂停几秒钟线程

try {

TimeUnit.SECONDS.sleep(2L);

} catch (InterruptedException e) {

e.printStackTrace();

}

new Thread(() -> {

flag = false;

}, "t2").start();

}

}

|

3、开销较低的读,写锁策略

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

public class UseVolatileDemo {

/**

* 使用:当读远多于写,结合使用 内部锁 和 volatile 变量来减少同步的开销

* 理由:利用volatile保证读取操作的可见性;利用synchronized保证复合操作的原子性

*/

public class Counter {

private volatile int value;

public int getValue() {

return value; //利用volatile保证读取操作的可见性

}

public synchronized int increment() {

return value++; //利用synchronized保证复合操作的原子性

}

}

}

|

DCL双重检查锁与延迟初始化

问题由来

在Java程序中,有时候可能需要推迟一些高开销的对象初始化操作,并且只有在使用这些对象时才进行初始化。此时,程序员可能会采用延迟初始化。但要正确实现线程安全的延迟初始化需要一些技巧,否则很容易出现问题。

synchronized(甚至是无竞争的synchronized)存在巨大的性能开销。因此,人们想出了一个“聪明”的技巧:双重检查锁定(Double-Checked Locking)。人们想通过双重检查锁定来降低同步的开销。

问题代码:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

public class SafeDoubleCheckSingleton {

private static SafeDoubleCheckSingleton singleton;

//私有化构造方法

private SafeDoubleCheckSingleton() {

}

//双重锁设计